不得不看的OpenAI 如何再次让 AI 圈一夜未眠

不出意外地,OpenAI的首届开发者大会,让人特别意外。

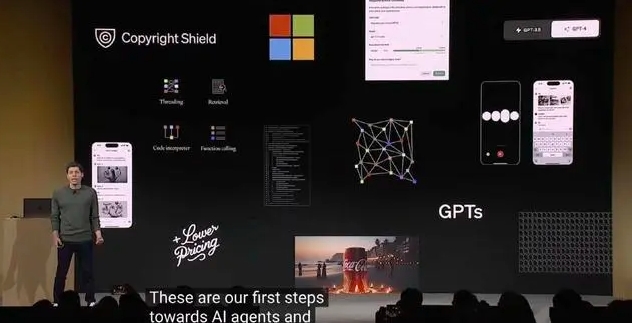

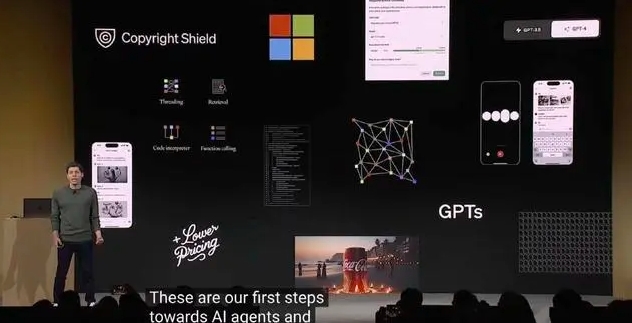

一夜醒来,大模型圈一只脚踏入了Agent的世界,另一只脚则踏入GPT Store生态的河流中。

美东时间11月6日,OpenAI开发者大会正式开启,创始人兼CEO山姆·奥特曼站在台上,45分钟的密集输出,再次展示了什么叫“遥遥领先”。

我们先简单回顾一下这场发布会的所有重点,其实无非就是三件事:

一是技术能力:GPT-4 Turbo升级了6大新能力,包括128K的上下文长度、更强的控制能力,模型的知识升级、多模态能力(语音和CV)、模型微调定制和更高速率的限制,性能升级的同时,还对API调用的价格进行了下调;

二是可复制的能力:从原来的GPT到GPTs,用户可以打造专属于自己的GPT助手,企业可通过OpenAI提供的全套工具链“all tools”在企业内部建设有价值的工具,同时也可以深入让GPTs进化为一个个Agents,为智能体做准备;

三则是生态能力:企业不仅可以打造GPTs,更能将其上架在市场内,即GPT Store,可分享给其他用户使用,以及获得分成,类App Store的商业生态由此为出发点。

正如网易有道CEO周枫所言,“这次模型上主要是性能和成本的优化,而在应用和生态方面,做了很多LangChain(开发工具链),LlamaIndex(开发数据框架)这些项目类似的工作,最终就是要实现以智能体作为AI App的愿景。”

总之,OpenAI提供的生态能力解决了当下大模型发展的几个重要难点,而在此之上,大模型的应用层将迎来进一步爆发。

“很兴奋,还有很多信息在消化。”

OpenAI发布之后,光锥智能在与多位国内知名大模型创业者交流中,也感受到了大家对行业前景的期待,“OpenAI的多模态能力开放,对开发者是很大的利好,可以做的事情的边界得到进一步拓展,我预计会有很多新的玩法出现。”月之暗面创始人杨植麟对光锥智能称。

这45分钟,为大模型火箭的二级爆发,再次添加燃料。

让大模型,飞入寻常百姓家

“有需求,打造生态,找落地。”OpenAI首届开发者大会结束后,某家国内大模型明星公司 CEO 对光锥智能发表了极为简短,却信息量极大的点评。

市场对ChatGPT的需求,无疑是巨大的。在发布会的开始,奥特曼报告了 OpenAI 平台和产品的一些数据,截至目前,已经有大约200万开发人员在其API上构建各种各样的应用,超过92%的全球500强企业正使用其产品,ChatGPT的周活跃用户达到大约一亿。

自GPT3.5问世到现在,每一次的升级都引领着大模型的下一个技术方向,不过,这次OpenAI GPT-4升级后的Turbo版本更像是查漏补缺。

首先是更长的上下文本长度,GPT-4Turbo上下文任务长度扩展至128K,相当于一本书的300多页,是 GPT-4支持的8K上下文的16倍。不仅如此,奥特曼还强调在扩展文本长度的同时,还应该保持模型的准确性。

其次是弥补OpenAI一直以来的短板——安全可控和知识库更新速度。针对前者,推出了名为Json Mode的新功能,确保开发人员更容易调用API,提升对模型输入和输出的控制;即将推出“Copyright Shield”(版权保护)功能,若其企业和API用户面临版权侵权诉讼,OpenAI将为其承担相应费用。针对后者,OpenAI平台支持用户导入文档、数据库来更新大模型的认知,同时还将新升级后的GPT-4Turbo认知理解更新到了2023年4月。

最后,此次更新中,OpenAI的多模态能力开放进入到了一个全新的阶段。上一个时期,OpenAI用了一年多的时间,实现了ChatGP能说、能看、能听,而现在才到了多模态能力释放的节点。DALL-E3、文生语音模型TTS(text-to-speech)、Whisper V3都将通过API的形式开放给开发者使用。

初建大模型生态

技术的迭代固然让人兴奋,工具的推出也让开发者们更加方便快捷,但更重要的是,OpenAI凭借一己之力,让大模型的商业化进一步落地。

如果您对OpenAI了解的还不够深刻,或者企业想引入OpenAI的功能,可以联系我们,助力企业的成长。